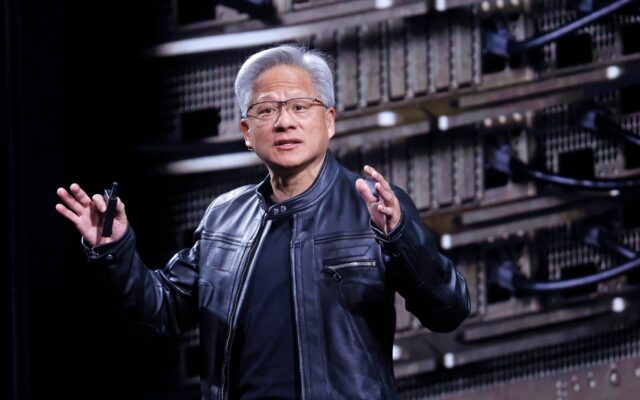

Hoje, na Consumer Electronics Show, o CEO da Nvidia, Jensen Huang, lançou oficialmente a nova arquitetura de computação Rubin da empresa, que ele descreveu como o que há de mais moderno em hardware de IA. A nova arquitetura está atualmente em produção e deverá aumentar ainda mais no segundo semestre do ano.

“Vera Rubin foi projetada para enfrentar este desafio fundamental que temos: a quantidade de computação necessária para a IA está disparando.” Huang disse ao público. “Hoje posso afirmar que Vera Rubin está em plena produção.”

A arquitetura Rubin, anunciada pela primeira vez em 2024, é o resultado mais recente do incansável ciclo de desenvolvimento de hardware da Nvidia, que transformou a Nvidia na empresa mais valiosa do mundo. A arquitetura Rubin substituirá a arquitetura Blackwell, que por sua vez substituiu as arquiteturas Hopper e Lovelace.

Os chips Rubin já estão programados para uso por quase todos os principais provedores de nuvem, incluindo parcerias de alto nível da Nvidia com Anthropic, OpenAI e Amazon Web Services. Os sistemas Rubin também serão usados no supercomputador Blue Lion da HPE e no próximo supercomputador Doudna no Laboratório Nacional Lawrence Berkeley.

Nomeada em homenagem à astrônoma Vera Florence Cooper Rubin, a arquitetura Rubin consiste em seis chips separados projetados para serem usados em conjunto. A GPU Rubin está no centro, mas a arquitetura também aborda gargalos crescentes no armazenamento e na interconexão com novas melhorias nos sistemas Bluefield e NVLink, respectivamente. A arquitetura também inclui uma nova CPU Vera, projetada para raciocínio de agente.

Explicando os benefícios do novo armazenamento, o diretor sênior de soluções de infraestrutura de IA da Nvidia, Dion Harris, apontou para as crescentes demandas de memória relacionadas ao cache dos sistemas modernos de IA.

“À medida que você começa a habilitar novos tipos de fluxos de trabalho, como IA de agência ou tarefas de longo prazo, isso coloca muito estresse e requisitos em seu cache KV”, disse Harris aos repórteres em uma teleconferência, referindo-se a um sistema de memória usado por modelos de IA para condensar entradas. “Portanto, introduzimos um novo nível de armazenamento que se conecta externamente ao dispositivo de computação, o que permite dimensionar seu pool de armazenamento com muito mais eficiência.”

Evento Techcrunch

São Francisco

|

13 a 15 de outubro de 2026

Como esperado, a nova arquitetura também representa um avanço significativo em velocidade e eficiência energética. De acordo com os testes da Nvidia, a arquitetura Rubin operará três vezes e meia mais rápido que a arquitetura Blackwell anterior em tarefas de treinamento de modelo e cinco vezes mais rápido em tarefas de inferência, chegando a 50 petaflops. A nova plataforma também suportará oito vezes mais computação de inferência por watt.

Os novos recursos de Rubin surgem em meio a uma intensa competição para construir infraestrutura de IA, que tem visto laboratórios de IA e provedores de nuvem lutarem por chips Nvidia, bem como pelas instalações necessárias para alimentá-los. Numa teleconferência de resultados em outubro de 2025, Huang estimou que entre US$ 3 trilhões e US$ 4 trilhões serão gastos em infraestrutura de IA nos próximos cinco anos.