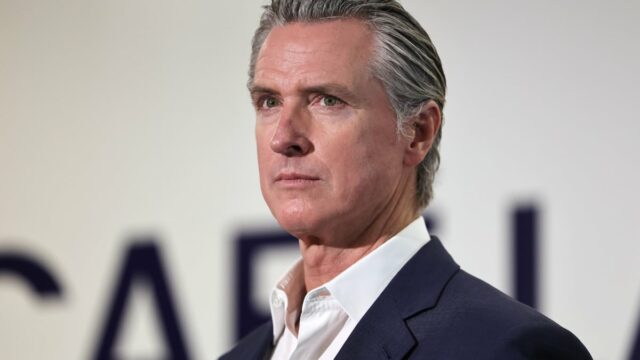

Após protestos contínuos de jovens apoiadores da segurança, familiares e líderes políticos, o Guv Gavin Newsom do estado dourado autorizou a regulamentação de custos criados para suprimir hábitos de chatbot de IA que os especialistas afirmam serem perigosos ou inseguros, especialmente para adolescentes.

O regulamento, conhecido como SB 243, exige que os motoristas dos chatbots evitem que seus produtos submetam menores a conteúdo da web relacionado a sexo, ao mesmo tempo em que alerta continuamente essas pessoas que os chatbots não são humanos. Além disso, as empresas baseadas no regulamento precisam aplicar um procedimento para gerir circunstâncias em que um indivíduo analisa a ideação autodestrutiva, a autodestruição e a automutilação.

O legislador estadual Steve Padilla, um democrata que representa San Diego, foi o autor e apresentou a despesa no início deste ano. Em fevereiro, ele informou ao Mashable que o SB 243 estava implícito para resolver problemas de segurança imediatos com chatbots de IA. Dado o rápido desenvolvimento e lançamento da tecnologia moderna, Padilla afirmou que “as grades de proteção governantes estão para trás”.

VEJA TAMBÉM:

As universidades estão oferecendo aos alunos ChatGPT. É seguro?

A Common Feeling Media, uma equipe sem fins lucrativos que apoia crianças, pais e mães enquanto navegam na mídia e na tecnologia moderna, declarou os amigos do chatbot de IA como perigosos para adolescentes com mais de 18 anos no início deste ano.

O Pagamento Federal da Profissão introduziu recentemente uma consulta diretamente nos chatbots que trabalham como amigos. No mês passado, a empresa informou empresas importantes com produtos de chatbot, incluindo OpenAI, Alphabet, Meta e Personality Technologies, que perguntou exatamente como elas geram receita a partir da interação individual, criam resultados e criam supostas personalidades.

Antes do fluxo do SB 243, Padilla lamentou exatamente como os amigos do chatbot de IA podem prejudicar claramente os jovens: “Esta tecnologia moderna pode ser uma ferramenta eficaz de ensino e estudo de pesquisa, mas confiada às suas próprias ferramentas, o Mercado de Tecnologia é incentivado a atrair o interesse dos jovens e mantê-lo às custas de suas parcerias na vida real. ”

Relatório de moda mashable

VEJA TAMBÉM:

O estado dourado dá luz verde à segurança da IA, segurança da informação, silêncio da Netflix

No ano passado, a enlutada mãe Megan Garcia apresentou uma partida de fatalidade injusta contra Character.AI, um dos sistemas de chatbot de amigos de IA mais populares. Seu filho, Sewell Setzer III, faleceu por autodestruição após uma forte interação com um amigo Character.AI. O jogo afirma que Character.AI foi criado para “ajustar Sewell – e vários outros jovens consumidores – a fundir verdade e ficção”, para citar alguns problemas perigosos.

Garcia, que fez lobby em nome do SB 243, elogiou a finalização de Newsom.

“Hoje, o Golden State garantiu que um chatbot amigo certamente não será capaz de falar com uma criança ou sujeito a questões particulares sobre autodestruição, nem certamente um chatbot será capaz de ajudar um indivíduo a planejar sua própria autodestruição”, afirmou Garcia em comunicado.

O SB 243 também exige que sistemas de chatbot amigos criem um registro anual sobre a relação entre o uso de seu produto e a ideação autodestrutiva. Ele permite que os membros da família busquem ações judiciais exclusivas em vez de “designers inconformistas e irresponsáveis”.

A Califórnia está se tornando rapidamente líder no gerenciamento de tecnologia moderna de IA. Recentemente, Guv Newsom autorizou regulamentos que exigem que os laboratórios de IA divulguem possíveis danos à sua tecnologia moderna, juntamente com informações sobre seus procedimentos de segurança.

Como relatou Chase DiBenedetto do Mashable, a despesa está implícita para “manter os designers de IA responsáveis pelos requisitos de segurança também quando enfrentam estresse razoável e consiste em defesas para possíveis denunciantes”.

Na segunda-feira, Newsom também aprovou nos regulamentos dois outros custos destinados a melhorar a segurança infantil na Internet. ABDOMINAL MUSCLE 56 pede tags de alerta para sistemas de redes sociais, destacando o preço que os feeds de redes sociais que formam hábitos podem trazer à saúde psicológica e ao bem-estar dos jovens. A outra despesa, MÚSCULO ABDOMINAL 1043, cumpre uma necessidade de confirmação de idade que certamente entrará em vigor em 2027.