Uma equipe de pesquisadores da Apple decidiu entender o que os usuários reais esperam dos agentes de IA e como eles preferem interagir com eles. Aqui está o que eles encontraram.

Apple explora tendências de UX para a era dos agentes de IA

No estudo, intitulado Mapeando o espaço de design da experiência do usuário para agentes de uso de computador, uma equipe de quatro pesquisadores da Apple afirma que, embora o mercado tenha investido pesadamente no desenvolvimento e avaliação de agentes de IA, alguns aspectos da experiência do usuário foram negligenciados: como os usuários podem querer interagir com eles e como deveriam ser essas interfaces.

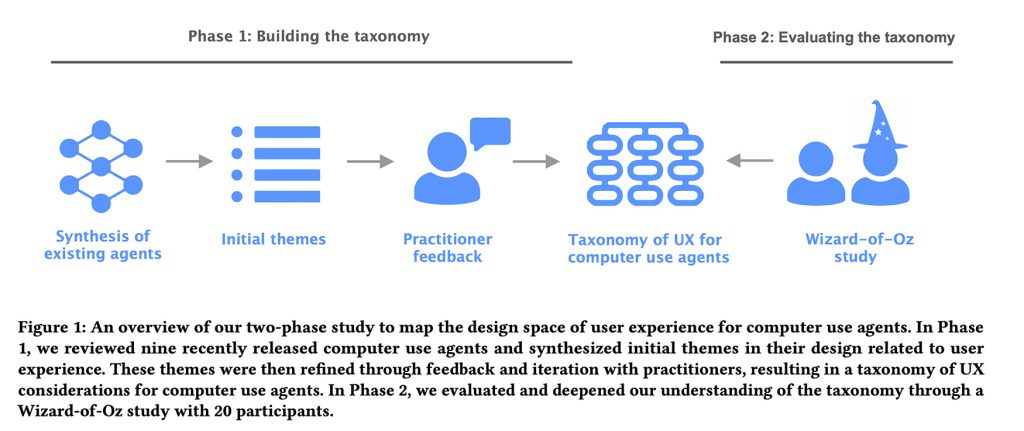

Para explorar isso, eles dividiram o estudo em duas fases: primeiro, identificaram os principais padrões de UX e considerações de design que os laboratórios de IA vêm incorporando aos agentes de IA existentes. Em seguida, eles testaram e refinaram essas ideias por meio de estudos práticos de usuários com um método interessante chamado Mágico de Oz.

Ao observar como esses padrões de design se comportam nas interações do usuário no mundo real, eles foram capazes de identificar quais designs atuais de agentes de IA se alinham com as expectativas do usuário e quais ficam aquém.

Fase 1: A taxonomia

Os pesquisadores analisaram nove agentes de desktop, móveis e baseados na web, incluindo;

- Ferramenta de uso de computador Claude

- Adepto

- Operador OpenAI

- AIlice

- UI Magentic

- UI-TARS

- Projeto Marinheiro

- TáxiAI

- AutoGLM

Em seguida, eles consultaram “8 profissionais que são designers, engenheiros ou pesquisadores que trabalham nas áreas de UX ou IA em uma grande empresa de tecnologia”, o que os ajudou a mapear uma taxonomia abrangente com quatro categorias, 21 subcategorias e 55 recursos de exemplo que cobrem as principais considerações de UX por trás dos agentes de IA que usam computadores.

As quatro categorias principais incluíam:

- Consulta do usuário: como os usuários inserem comandos

- Explicabilidade das atividades do agente: quais informações apresentar ao usuário sobre as ações do agente

- Controle de usuário: como os usuários podem intervir

- Modelo Mental e Expectativas: como ajudar os usuários a entender os recursos do agente

Em essência, essa estrutura abrangeu tudo, desde aspectos da interface que permitem que os agentes apresentem seus planos aos usuários, até como eles comunicam suas capacidades, revelam erros e permitem que os usuários intervenham quando algo dá errado.

Com tudo isso em mãos, eles passaram para a fase 2.

Fase 2: O estudo do Mágico de Oz

Os pesquisadores recrutaram 20 usuários com experiência anterior com agentes de IA e pediram-lhes que interagissem com um agente de IA por meio de uma interface de chat para realizar uma tarefa de aluguel por temporada ou uma tarefa de compras online.

Do estudo:

Os participantes receberam uma interface simulada de bate-papo por meio da qual puderam interagir com um “agente” interpretado pelo pesquisador. Enquanto isso, o participante também foi apresentado à interface de execução do agente, onde o pesquisador atuou como agente e interagiu com o Ul na tela com base no comando do participante. Na interface de chat do usuário, os participantes podiam inserir consultas textuais em linguagem natural, que então apareciam no tópico do chat. Em seguida, o “agente” iniciou a execução, onde o pesquisador controlou o mouse e o teclado para simular as ações do agente na página web. Quando o pesquisador concluiu a tarefa, ele inseriu uma tecla de atalho que postou uma mensagem de “tarefa concluída” no tópico do chat. Durante a execução, os participantes poderiam usar um botão de interrupção para parar o agente, e uma mensagem “agente interrompido” apareceria no chat.

Ou seja, sem o conhecimento dos usuários, o agente de IA era, na verdade, um pesquisador sentado na sala ao lado, que lia as instruções do texto e executava a tarefa solicitada.

Para cada tarefa (aluguel por temporada ou compras on-line), os participantes foram solicitados a realizar seis funções com a ajuda do agente de IA, algumas das quais o agente falharia propositalmente (como ficar preso em um loop de navegação) ou cometeria erros intencionais (como selecionar algo diferente das instruções do usuário).

Ao final de cada sessão, os pesquisadores pediram aos participantes que refletissem sobre sua experiência e propusessem recursos ou mudanças para melhorar a interação.

Eles também analisaram gravações de vídeo e registros de bate-papo de cada sessão para identificar temas recorrentes no comportamento do usuário, expectativas e pontos problemáticos ao interagir com o agente.

Principais conclusões

Depois de tudo dito e feito, os pesquisadores descobriram que os usuários desejam ter visibilidade sobre o que os agentes de IA estão fazendo, mas não microgerenciar cada etapa, caso contrário, eles poderiam simplesmente executar as tarefas sozinhos.

Eles também concluíram que os usuários desejam comportamentos diferentes dos agentes, dependendo se estão explorando opções ou executando uma tarefa familiar. Da mesma forma, as expectativas do usuário mudam dependendo de ele estar familiarizado com a interface. Quanto menos familiarizados eles estavam, mais queriam transparência, etapas intermediárias, explicações e pausas de confirmação (mesmo em cenários de baixo risco).

Descobriram também que as pessoas querem mais controlo quando as ações têm consequências reais (como fazer compras, alterar dados de conta ou de pagamento, ou contactar outras pessoas em seu nome) e também descobriram que a confiança se quebra rapidamente quando os agentes fazem suposições ou erros silenciosos.

Por exemplo, quando o agente encontrava escolhas ambíguas em uma página ou se desviava do plano original sem sinalizá-lo claramente, os participantes instruíam o sistema a fazer uma pausa e pedir esclarecimentos, em vez de apenas escolher algo aparentemente aleatório e seguir em frente.

Na mesma linha, os participantes relataram desconforto quando o agente não era transparente ao fazer uma determinada escolha, especialmente quando essa escolha poderia levar à seleção do produto errado.

Resumindo, este é um estudo interessante para desenvolvedores de aplicativos que desejam adotar recursos de agente em seus aplicativos, e você pode lê-lo na íntegra aqui.

Ofertas de acessórios na Amazon

FTC: Usamos links de afiliados automotivos para geração de renda. Mais.