A Apple continua a explorar como a IA generativa pode melhorar os pipelines de desenvolvimento de aplicativos. Aqui está o que eles estão olhando.

Um pouco de fundo

Há alguns meses, uma equipe de pesquisadores da Apple publicou um estudo interessante sobre o treinamento de IA para gerar código de UI funcional.

Em vez da qualidade do design, o estudo se concentrou em garantir que o código gerado pela IA realmente fosse compilado e correspondesse aproximadamente ao prompt do usuário em termos de como a interface deveria fazer e se parecer.

O resultado foi UICoder, uma família de modelos de código aberto sobre a qual você pode ler mais aqui.

O novo estudo

Agora, uma parte da equipe responsável pelo UICoder lançou um novo artigo intitulado “Melhorando modelos de geração de interface do usuário a partir do feedback do designer”.

Nele, os pesquisadores explicam que os métodos existentes de Aprendizagem por Reforço a partir de Feedback Humano (RLHF) não são os melhores métodos para treinar LLMs para gerar UIs bem projetadas de maneira confiável, uma vez que “não estão bem alinhados com os fluxos de trabalho dos designers e ignoram a rica lógica usada para criticar e melhorar os designs de UI”.

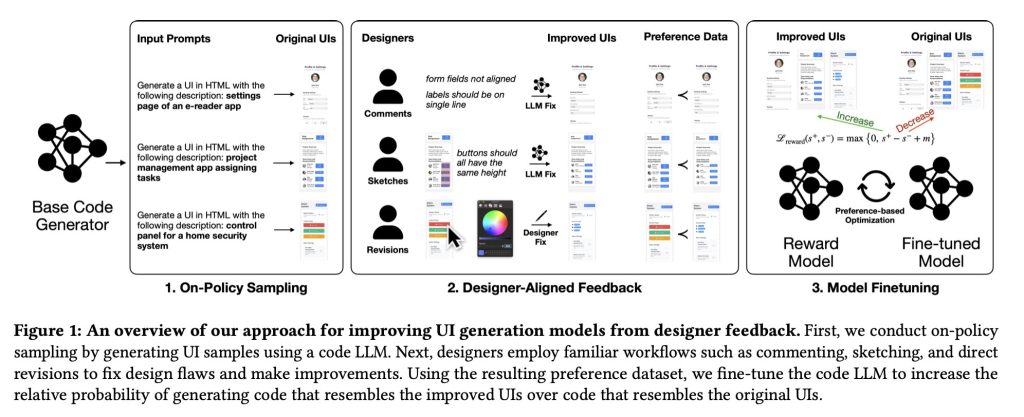

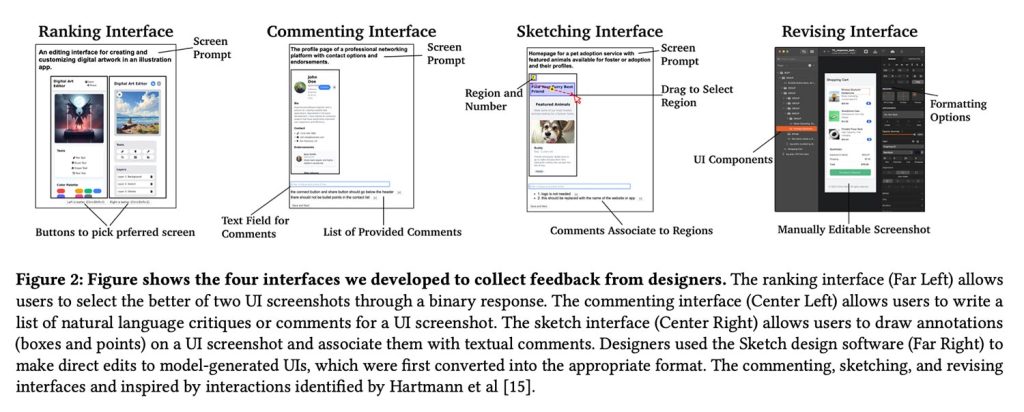

Para resolver esse problema, eles propuseram um caminho diferente. Eles fizeram com que designers profissionais criticassem e aprimorassem diretamente as UIs geradas pelo modelo usando comentários, esboços e até mesmo edições práticas e, em seguida, converteram essas alterações antes e depois em dados usados para ajustar o modelo.

Isso permitiu que eles treinassem um modelo de recompensa em melhorias concretas de design, ensinando efetivamente o gerador de UI a preferir layouts e componentes que refletissem melhor o julgamento de design do mundo real.

A configuração

No total, 21 designers participaram do estudo:

Os participantes recrutados tinham níveis variados de experiência profissional em design, variando de 2 a mais de 30 anos. Os participantes também trabalharam em diferentes áreas do design, como design UI/UX, design de produto e design de serviço. Os designers participantes também observaram a frequência da realização de revisões de design (formais e informais) nas atividades de trabalho: variando de uma vez a cada poucos meses a várias vezes por semana.

Os pesquisadores coletaram 1.460 anotações, que foram então convertidas em exemplos de “preferências” de UI emparelhadas, contrastando a interface original gerada pelo modelo com as versões melhoradas dos designers.

Isso, por sua vez, foi usado para treinar um modelo de recompensa para ajustar o gerador de UI:

O modelo de recompensa aceita i) uma imagem renderizada (uma captura de tela da IU) e ii) uma descrição em linguagem natural (uma descrição alvo da IU). Essas duas entradas são inseridas no modelo para produzir uma pontuação numérica (recompensa), que é calibrada para que designs visuais de melhor qualidade resultem em pontuações maiores. Para atribuir recompensas ao código HTML, usamos o pipeline de renderização automatizado descrito na Seção 4.1 para primeiro renderizar o código em capturas de tela usando software de automação de navegador.

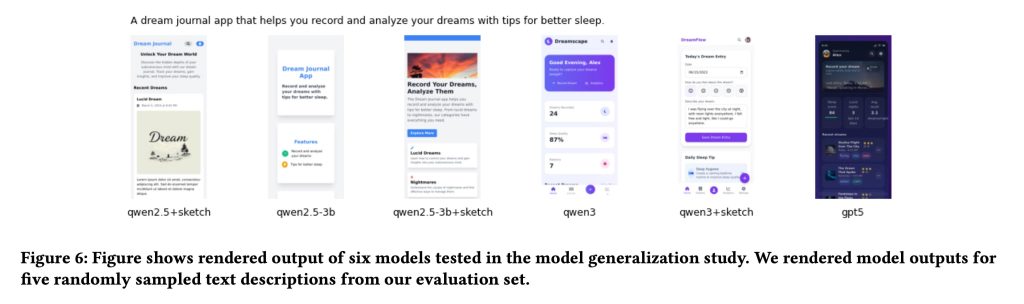

Quanto aos modelos geradores, a Apple usou Qwen2.5-Coder como modelo base primário para geração de UI e, posteriormente, aplicou o mesmo modelo de recompensa treinado pelo designer a variantes Qwen menores e mais recentes para testar quão bem a abordagem se generalizou em diferentes tamanhos e versões de modelos.

Curiosamente, como observam os próprios autores do estudo, essa estrutura acaba se parecendo muito com um pipeline RLHF tradicional. A diferença, argumentam eles, é que o sinal de aprendizagem vem de fluxos de trabalho nativos do designer (comentários, esboços e revisões práticas), e não como aprovação/rejeição ou simples dados de classificação.

Os resultados

Então, realmente funcionou? Segundo os pesquisadores, a resposta é sim, com ressalvas importantes.

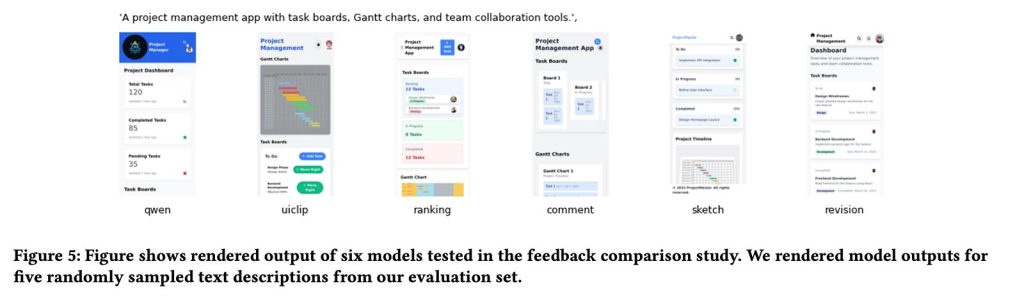

Em geral, os modelos treinados com feedback nativo do designer (especialmente com esboços e revisões diretas) produziram designs de UI de qualidade visivelmente mais alta do que os modelos básicos e as versões treinadas usando apenas dados convencionais de classificação ou classificação.

Na verdade, os pesquisadores observaram que seu modelo de melhor desempenho (Qwen3-Coder ajustado com feedback de esboço) superou o GPT-5. Talvez o mais impressionante seja o fato de que isso foi derivado de apenas 181 anotações de esboços de designers.

Nossos resultados mostram que o ajuste fino com nosso modelo de recompensa baseado em esboço levou consistentemente a melhorias nos recursos de geração de UI para todas as linhas de base testadas, sugerindo generalização. Também mostramos que uma pequena quantidade de feedback de especialistas de alta qualidade pode permitir com eficiência que modelos menores superem LLMs proprietários maiores na geração de UI.

Quanto à advertência, os pesquisadores observaram que a subjetividade desempenha um papel importante quando se trata do que exatamente constitui uma boa interface:

Um grande desafio do nosso trabalho e de outros problemas centrados no ser humano é lidar com a subjetividade e as múltiplas resoluções de problemas de design. Ambos os fenómenos também podem levar a uma grande variação nas respostas, o que coloca desafios aos mecanismos de feedback de classificação amplamente utilizados.

No estudo, esta variação manifestou-se como discordância sobre quais designs eram realmente melhores. Quando os pesquisadores avaliaram independentemente os mesmos pares de UI que os designers classificaram, eles concordaram com as escolhas dos designers apenas 49,2% das vezes, apenas um cara ou coroa.

Por outro lado, quando os designers forneceram feedback esboçando melhorias ou editando diretamente as UIs, a equipe de pesquisa concordou com essas melhorias com muito mais frequência: 63,6% para esboços e 76,1% para edições diretas.

Em outras palavras, quando os designers podiam mostrar especificamente o que queriam mudar, em vez de apenas escolher entre duas opções, era mais fácil concordar sobre o que “melhor” realmente significava.

Para uma análise mais aprofundada do estudo, incluindo mais aspectos técnicos, material de treinamento e mais exemplos de interfaces, siga este link.

Ofertas de acessórios na Amazon

FTC: Usamos links de afiliados automotivos para geração de renda. Mais.