A Microsoft implantou esta semana sua primeira safra de chips de IA desenvolvidos internamente em um de seus data centers, com planos de lançar mais nos próximos meses, afirma.

O chip, chamado Maia 200, foi projetado para ser o que a Microsoft chama de “potência de inferência de IA”, como a Microsoft descreve, o que significa que é otimizado para o trabalho intensivo de computação de execução de modelos de IA em produção. A empresa divulgou algumas especificações impressionantes de velocidade de processamento para Maia, dizendo que ele supera os mais recentes chips Trainium da Amazon e as mais recentes unidades de processamento tensor (TPU) do Google.

Todos os gigantes da nuvem estão recorrendo a seus próprios designs de chips de IA, em parte por causa da dificuldade e do custo de obter o que há de melhor e mais recente da Nvidia – uma crise de fornecimento que não mostra sinais de diminuir.

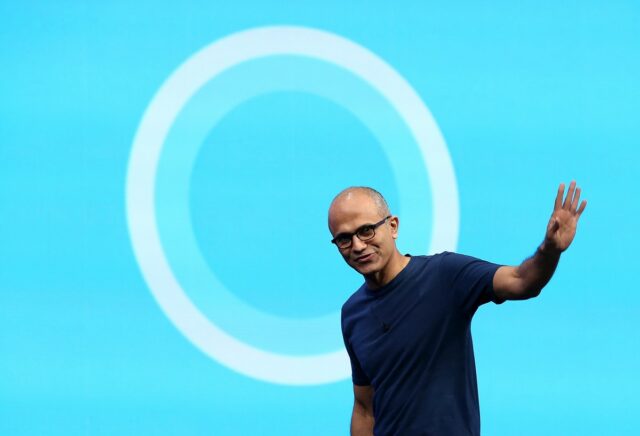

Mas mesmo com seu próprio chip de última geração e alto desempenho em mãos, o CEO da Microsoft, Satya Nadella, disse que a empresa ainda comprará chips fabricados por terceiros.

“Temos uma grande parceria com a Nvidia, com a AMD. Eles estão inovando. Estamos inovando”, explicou. “Acho que muitas pessoas apenas falam sobre quem está à frente. Lembre-se, você tem que estar à frente para sempre.”

Ele acrescentou: “O fato de podermos integrar verticalmente não significa que integramos apenas verticalmente”, ou seja, construir seus próprios sistemas de cima para baixo, sem usar produtos de outros fornecedores.

Dito isto, o Maia 200 será usado pela chamada equipe de Superinteligência da Microsoft, os especialistas em IA que constroem os próprios modelos de fronteira da gigante do software. Isso é de acordo com Mustafa Suleyman, ex-cofundador do Google DeepMind que agora lidera a equipe. A Microsoft está trabalhando em seus próprios modelos para talvez um dia diminuir sua dependência de OpenAI, Anthropic e outros fabricantes de modelos.

Evento Techcrunch

Boston, MA

|

23 de junho de 2026

O chip Maia 200 também suportará modelos OpenAI executados na plataforma de nuvem Azure da Microsoft, afirma a empresa. Mas, segundo todos os relatos, garantir o acesso ao hardware de IA mais avançado ainda é um desafio para todos, tanto para clientes pagantes quanto para equipes internas.

Então, em uma postagem no X, Suleyman claramente gostou de compartilhar a notícia de que sua equipe recebe a prioridade. “É um grande dia”, escreveu ele quando o chip foi lançado. “Nossa equipe de Superinteligência será a primeira a usar o Maia 200 à medida que desenvolvemos nossos modelos de IA de ponta.”