O modelo, chamado SHARP, pode reconstruir uma cena 3D fotorrealista a partir de uma única imagem em menos de um segundo. Aqui estão alguns exemplos.

SHARP é simplesmente incrível

A Apple publicou um estudo intitulado Sharp Monocular View Synthesis in Less Than a Second, no qual detalha como treinou um modelo para reconstruir uma cena 3D a partir de uma única imagem 2D, mantendo distâncias e escala consistentes em termos do mundo real.

Veja como os pesquisadores da Apple apresentam o estudo:

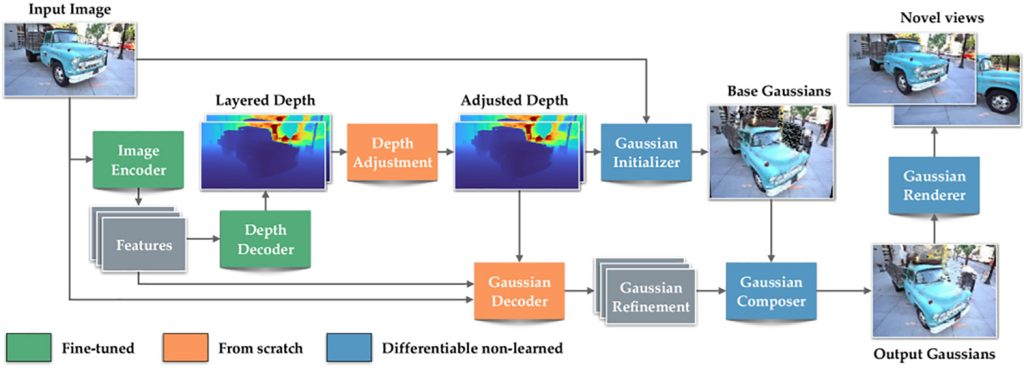

Apresentamos SHARP, uma abordagem para síntese de visão fotorrealista a partir de uma única imagem. Dada uma única fotografia, o SHARP regride os parâmetros de uma representação gaussiana 3D da cena representada. Isso é feito em menos de um segundo em uma GPU padrão por meio de uma única passagem feedforward através de uma rede neural. A representação gaussiana 3D produzida pelo SHARP pode então ser renderizada em tempo real, produzindo imagens fotorrealistas de alta resolução para vistas próximas. A representação é métrica, com escala absoluta, suportando movimentos de câmera métricos. Resultados experimentais demonstram que o SHARP oferece generalização robusta e imediata em conjuntos de dados. Ele estabelece um novo estado da arte em vários conjuntos de dados, reduzindo LPIPS em 25–34% e DISTS em 21–43% em comparação ao melhor modelo anterior, ao mesmo tempo que reduz o tempo de síntese em três ordens de magnitude.

Resumindo, o modelo prevê uma representação 3D da cena, que pode ser renderizada a partir de pontos de vista próximos.

Uma Gaussiana 3D é basicamente uma pequena bolha difusa de cor e luz, posicionada no espaço. Quando milhões desses blobs são combinados, eles podem recriar uma cena 3D que parece precisa daquele ponto de vista específico.

Para criar esse tipo de representação 3D, a maioria das abordagens de respingos gaussianos requerem dezenas ou até centenas de imagens da mesma cena, capturadas de diferentes pontos de vista. O modelo SHARP da Apple, por outro lado, é capaz de prever uma representação completa de cena gaussiana em 3D a partir de uma única foto em uma passagem direta de uma rede neural.

Para conseguir isso, a Apple treinou o SHARP em grandes quantidades de dados sintéticos e do mundo real, permitindo-lhe aprender padrões comuns de profundidade e geometria em múltiplas cenas.

Como resultado, ao receber uma nova foto, o modelo estima a profundidade, refina-a usando o que aprendeu e, em seguida, prevê a posição e a aparência de milhões de gaussianas 3D em uma única passagem.

Isso permite que o SHARP reconstrua uma cena 3D plausível sem a necessidade de múltiplas imagens ou otimização lenta por cena.

Há uma compensação, no entanto. O SHARP renderiza com precisão pontos de vista próximos, em vez de sintetizar partes totalmente invisíveis da cena. Isso significa que os usuários não podem se afastar muito do ponto de vista de onde a foto foi tirada, já que o modelo não sintetiza partes totalmente invisíveis da cena.

É assim que a Apple mantém o modelo rápido o suficiente para gerar o resultado em menos de um segundo, bem como estável o suficiente para criar um resultado mais verossímil. Aqui está uma comparação entre SHARP e Gen3C, que é um dos métodos anteriores mais fortes:

Talvez mais interessante do que acreditar na palavra da Apple seja tentar fazer isso por si mesmo.. Para esse fim, a Apple disponibilizou o SHARP no GitHub, e os usuários têm compartilhado seus próprios resultados com seus testes.

Aqui estão algumas postagens que usuários X compartilharam nos últimos dias:

Novo artigo da Apple – Síntese de visão monocular nítida em menos de um segundo

Mescheder et al. A @ Apple acaba de lançar um artigo muito impressionante (parabéns! ). Você fornece uma imagem e ela gera uma representação gaussiana 3D de ótima aparência. Usa profundidade profissional. É muito bom.… pic.twitter.com/XSZCZA8iio

-Tim Davison ᯅ (@timd_ca) 16 de dezembro de 2025

Você deve ter notado que a última postagem é na verdade um vídeo. Isso vai além do escopo original da Apple para o SHARP e mostra outras maneiras pelas quais este modelo, ou pelo menos sua abordagem subjacente, poderia ser estendido em trabalhos futuros.

Se você decidir experimentar o SHARP, compartilhe os resultados conosco nos comentários abaixo.

Ofertas de acessórios na Amazon

FTC: Usamos links de afiliados automotivos para geração de renda. Mais.