Ideia53:59Uma chamada para ‘justiça algorítmica’ à luz do viés da IA

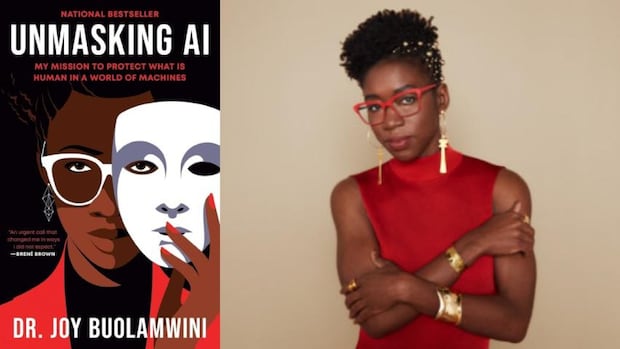

Joy Buolamwini está na vanguarda da pesquisa sobre inteligência artificial e observa que os sistemas de IA causaram danos causados por viés racial, preconceitos e habilidades de gênero. Ela é a fundadora da Liga da Justiça Algorítmica, uma organização que trabalha para tornar a IA responsável.

“O limite crescente dos direitos civis exigirá a justiça algorítmica. A IA deve ser para as pessoas e pelo povo, não apenas pelos poucos privilegiados”, escreve Buolamwini.

Sua pesquisa como estudante de graduação no MIT a levou a ligar para a Microsoft, IBM, Amazon e outros gigantes técnicos – cujos sistemas de reconhecimento de rosto não foram capazes de identificar a cor da cor. Os piores resultados foram relacionados a mulheres com pele escura. Para piorar a situação, esse mau software para reconhecimento de rosto já estava em uso por empresas e agências policiais.

Ela descobriu os limites da detecção facial enquanto trabalhava em um projeto criativo de computador.

“A detecção facial não detectou meu rosto até que eu liguei uma máscara branca. Era hora de Halloween, eu tinha uma máscara branca no bairro. Puxe a máscara branca, o rosto da máscara branca é detectada. Detende, meu rosto com pele escura, o rosto humano, o rosto real, não detectado.

Nos anos seguintes, ela foi uma defensora feroz para a correção do viés algorítmico, o que ela diz ser um problema que a sociedade custará muito se não for abordada.

Aqui está um trecho da Palestra de Broolwini de Joy Buolamwini, entregue à Escola de Políticas Públicas de Sanford na Universidade Duke em fevereiro de 2025.

‘Mostre as mãos. Quanto o olhar masculino ouviu? O olhar branco? A aparência pós -colonial?

“Eu acrescento com a aparência codificada a esse léxico, e é realmente um reflexo do poder. Quem tem o poder de moldar as prioridades, as preferências – e às vezes, talvez não intencionalmente – os preconceitos incorporados na tecnologia?

“Eu me deparei com o olhar criptografado como um estudante de graduação que trabalhou em uma instalação de arte … Eu literalmente tive que colocar uma máscara branca para deixar minha pele escura detectar. Meu amigo, não tanto. Este foi o meu primeiro encontro com o olhar codificado.

“Eu compartilhei a história de codificar uma máscara branca na plataforma TEDX. Muitas pessoas a viram. Então, pensei, você sabe o quê? As pessoas podem querer verificar minhas reivindicações – deixe -me me verificar”.

“Peguei meu perfil do TEDX e comecei a liderá -lo através de demos on -line de diferentes empresas. E descobri que algumas empresas não detectaram meu rosto. E aqueles que me abusaram como homem. Então, me perguntei se esse era apenas meu rosto ou rosto de outras pessoas.

“Então é o Mês da História Negra (a palestra foi registrada em fevereiro de 2025). Fiquei empolgado em executar uma parte do elenco da Pantera Negra. Em alguns casos, não há detecção. Em outros casos, há um maus -tratos … você tem Angela Bassett – ela tem 59 anos nesta foto. Talvez todos os preconceitos sejam o pior.

“O que me deixou preocupado foi ir além dos personagens fictícios e pensar nas maneiras pelas quais a IA, e especialmente o reconhecimento de face de campo da IA, aparece no mundo.

“O que leva a coisas como prisões falsas, falses profundas não consensuais também para imagens explícitas. E isso influencia todos, especialmente se você tiver empresas como a Clearview AI, que abandonaram bilhões de fotos graças às plataformas de mídia social. Não é que lhes demos permissão, mas foi o que eles fizeram.

“Então, se pensarmos em onde estamos nesta fase do desenvolvimento da IA, muitas vezes penso no operado -o explodido representa todos que foram condenados, condenados, explorados, danificados pelos sistemas de IA”.

A inteligência artificial e a tecnologia de reconhecimento de rosto são usadas em um público denso na exposição Horizon Robotics no Las Vegas Convention Center, 10 de janeiro de 2019. (David McNew/AFP via Getty Images)

“Estou pensando em pessoas como Porcha Woodruff, que estava grávida de oito meses quando foi falsamente presa por identificação errada do reconhecimento de rosto. Ela até relatou que tinha contrações enquanto estava mantido. O que é louco por sua história é que alguns anos antes, o mesmo departamento de polícia prendeu falsamente por suas duas jovens e esposa.

“Portanto, este não é um caso em que não sabíamos que havia problemas. Exatamente. Mas, em alguns casos, era negligência deliberada continuar usando sistemas que foram mostrados várias vezes para ter todos os tipos de preconceitos prejudiciais. Esses algoritmos continuam a existir. E isso é uma maneira de ser adiada”.

“Outra maneira é que temos algoritmos de vigilância.

“Alguns de vocês, enquanto voam para casa para as férias ou outros lugares, provavelmente começará a ver o aeroporto escaneando rastejando. E assim a mão da supervisão continua a se estender.

“E então você tem algoritmos de exploração. Você não salvará celebridades. A pele mais clara não o salvará. Vimos com a ascensão de sistemas generativos de IA, a possibilidade de criar uma falsa profunda e imitar pessoas, seja não consensual, fotos explícitas de Taylor Swift of Tom Hanks que você nunca ouve uma casa devora” “.

Baixar o Podcast de idéias Para ouvir o episódio inteiro.

*Cright continua por clareza e comprimento. Este episódio foi produzido por Seán Foley.