Os pesquisadores da Apple desenvolveram um modelo de IA que melhora drasticamente fotos extremamente escuras, integrando um modelo de imagem baseado em difusão diretamente no pipeline de processamento de imagem da câmera, permitindo recuperar detalhes de dados brutos do sensor que normalmente seriam perdidos. Veja como eles fizeram isso.

O problema com fotos com pouca luz

Você provavelmente tirou uma foto em condições muito escuras, o que resultou em uma imagem cheia de ruído digital granulado.

Isso acontece quando o sensor de imagem não capta luz suficiente.

Para tentar compensar isso, empresas como a Apple têm aplicado algoritmos de processamento de imagem que foram criticados por criarem efeitos excessivamente suaves, semelhantes a pinturas a óleo, onde pequenos detalhes desaparecem ou são reconstruídos em algo dificilmente reconhecível ou legível.

Digite DarkDiff

Para resolver esse problema, pesquisadores da Apple e da Purdue University desenvolveram um modelo chamado DarkDiff. Veja como eles apresentam isso em um estudo chamado DarkDiff: Advancing Low-Light Raw Enhancement by Retasking Diffusion Models for Camera ISP:

Fotografia de alta qualidade em condições de pouca luz é desafiadora, mas impactante para câmeras digitais. Com hardware de computação avançado, os algoritmos tradicionais do processador de sinal de imagem de câmera (ISP) estão sendo gradualmente substituídos por redes profundas e eficientes que aprimoram imagens brutas com ruído de maneira mais inteligente. No entanto, os modelos existentes baseados em regressão geralmente minimizam erros de pixel e resultam em suavização excessiva de fotos com pouca luz ou sombras profundas. Trabalhos recentes tentaram resolver essa limitação treinando um modelo de difusão do zero, mas esses modelos ainda lutam para recuperar detalhes nítidos da imagem e cores precisas. Introduzimos uma nova estrutura para aprimorar imagens brutas com pouca luz, retarefando modelos de difusão generativa pré-treinados com o ISP da câmera. Experimentos extensos demonstram que nosso método supera o que há de mais moderno em qualidade perceptiva em três benchmarks desafiadores de imagens brutas com pouca luz.

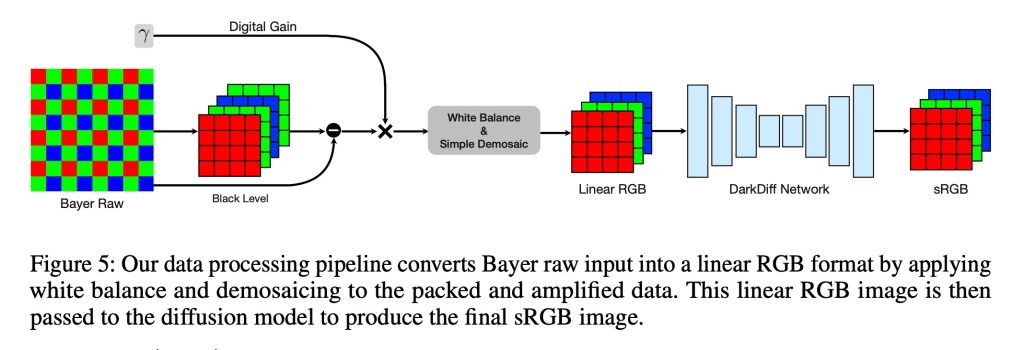

Em outras palavras, em vez de aplicar IA no estágio de pós-processamento, eles reorganizaram o Stable Diffusion (um modelo de código aberto treinado em milhões de imagens) para entender quais detalhes deveriam existir nas áreas escuras das fotos, considerando seu contexto geral, e integraram-no ao pipeline de processamento de sinal de imagem.

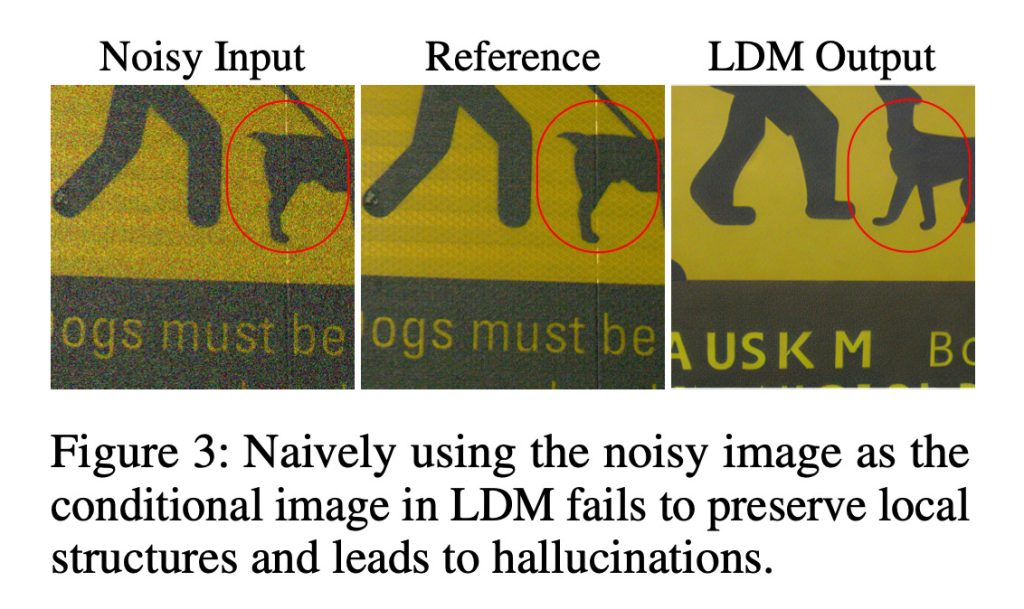

Na verdade, a abordagem deles introduz um mecanismo que computa a atenção sobre manchas de imagens localizadas, o que ajuda a preservar estruturas locais e atenua alucinações como na imagem abaixo, onde a IA de reconstrução altera completamente o conteúdo da imagem.

Com esta abordagem, o ISP da câmera ainda lida com o processamento inicial necessário para dar sentido aos dados brutos do sensor, incluindo etapas como equilíbrio de branco e demosaicing. DarkDiff então opera nesta imagem RGB linear, eliminando-a e produzindo diretamente a imagem sRGB final.

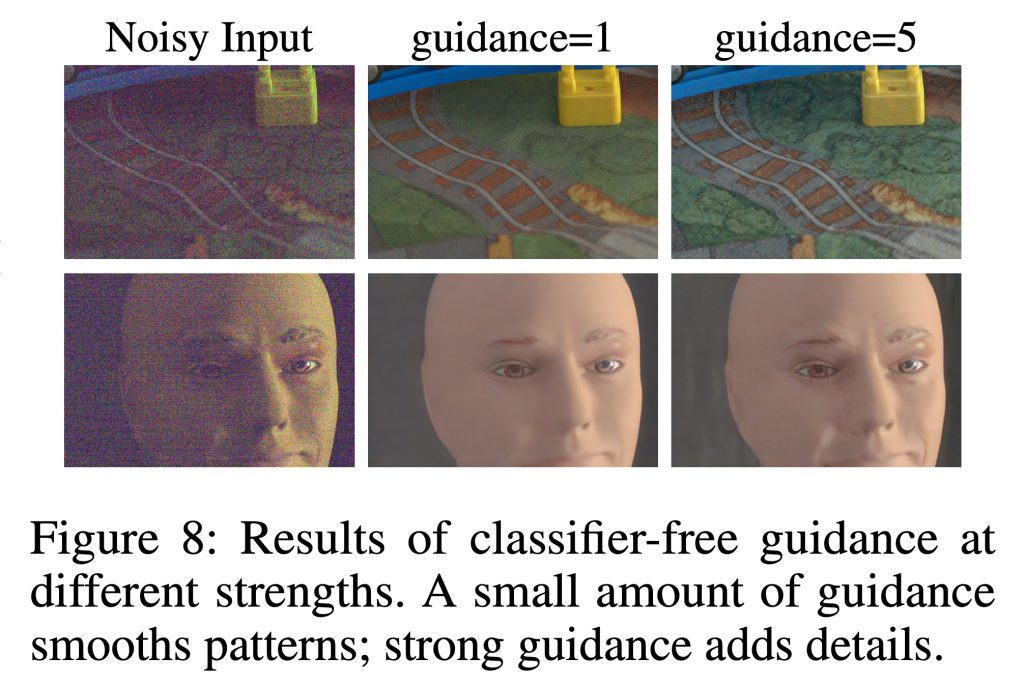

DarkDiff também usa uma técnica de difusão padrão chamada orientação sem classificador, que basicamente controla a intensidade com que o modelo deve seguir a imagem de entrada, em comparação com seus antecedentes visuais aprendidos.

Com orientação mais baixa, o modelo produz padrões mais suaves, enquanto a orientação crescente o incentiva a gerar texturas mais nítidas e detalhes mais finos (o que, por sua vez, também aumenta o risco de produzir artefatos indesejados ou conteúdo alucinado).

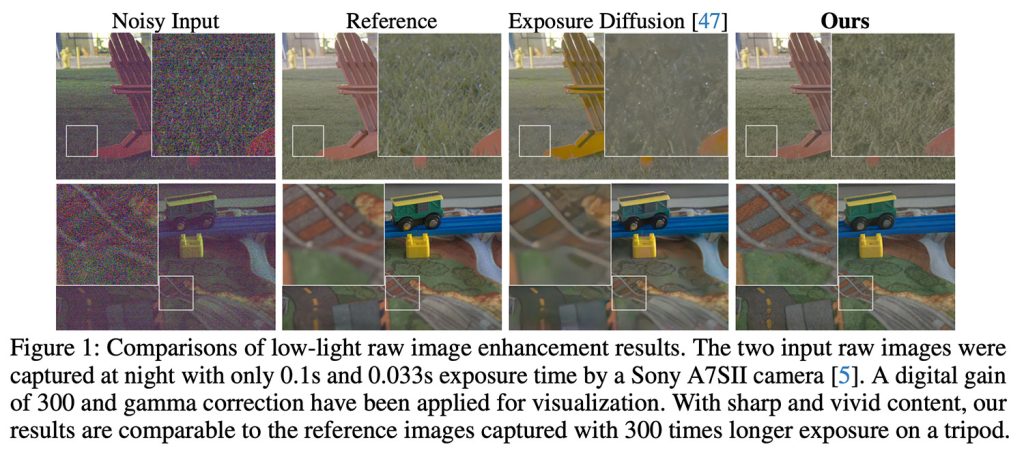

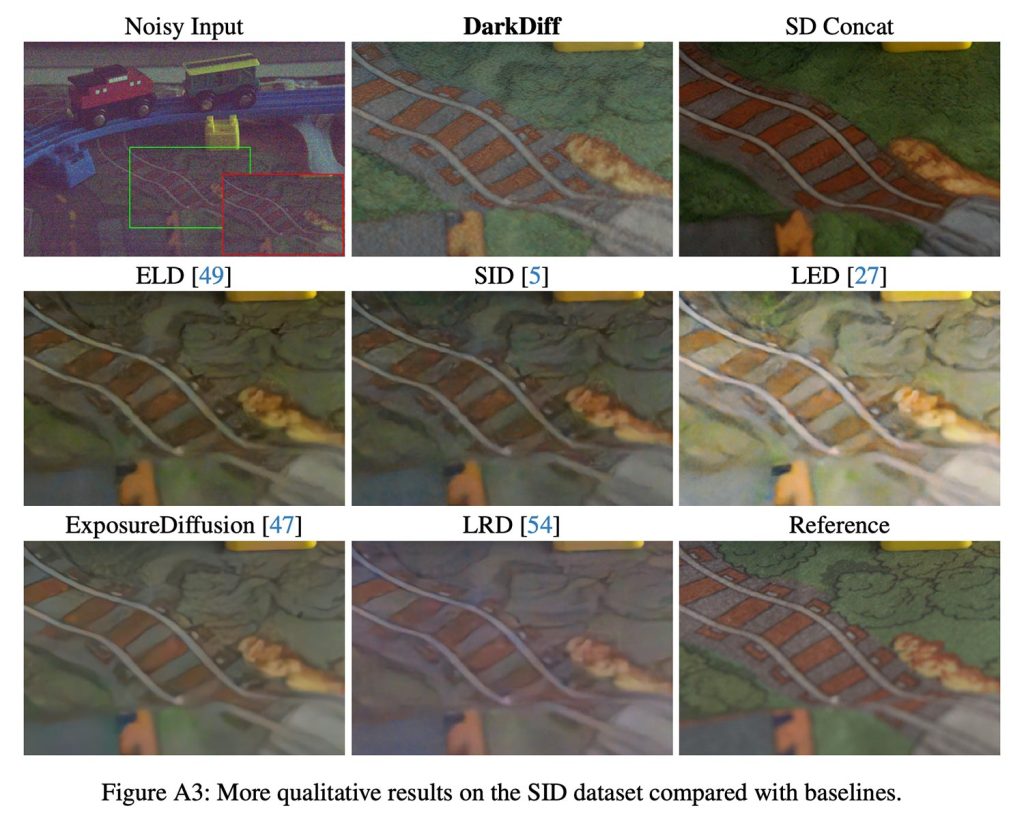

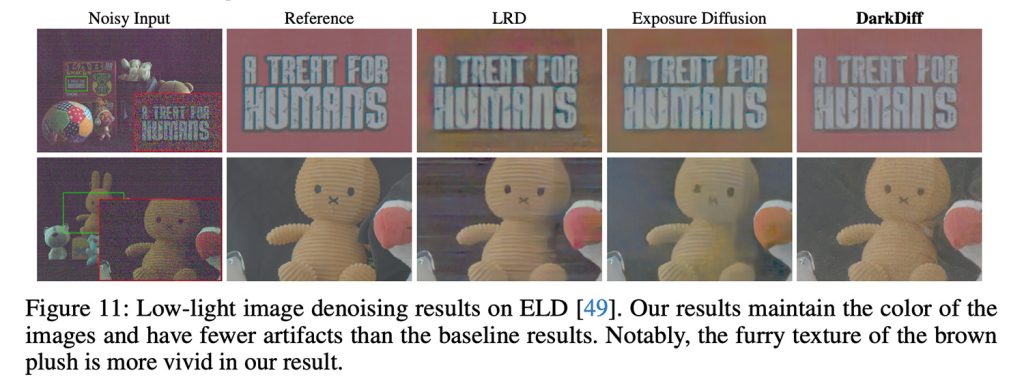

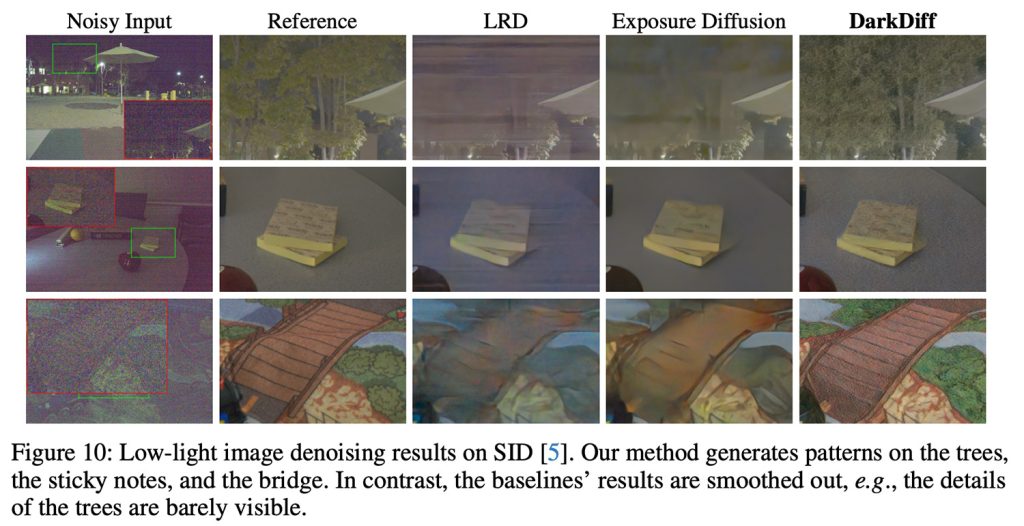

Para testar o DarkDiff, os pesquisadores usaram fotos reais tiradas com pouca luz com câmeras como a Sony A7SII, comparando os resultados com outros modelos de aprimoramento bruto e linhas de base baseadas em difusão, incluindo ExposureDiffusion.

As imagens de teste foram capturadas à noite com tempos de exposição tão curtos quanto 0,033 segundos, e as versões aprimoradas do DarkDiff foram comparadas com fotos de referência capturadas com exposição 300 vezes maior em um tripé.

Aqui estão alguns dos resultados (que encorajamos você a ver com qualidade total no estudo original):

DarkDiff tem seus problemas

Os pesquisadores observam que seu processamento baseado em IA é significativamente mais lento do que os métodos tradicionais e provavelmente exigiria processamento em nuvem para compensar os altos requisitos computacionais que esgotariam rapidamente a bateria se executados localmente em um telefone. Além disso, eles também observam limitações no reconhecimento de texto em idiomas diferentes do inglês em cenas com pouca luz.

Também é importante observar que em nenhum lugar do estudo é sugerido que o DarkDiff chegará aos iPhones tão cedo. Ainda assim, o trabalho demonstra o foco contínuo da Apple nos avanços da fotografia computacional.

Nos últimos anos, esta tornou-se uma área de interesse cada vez mais importante em todo o mercado de smartphones, à medida que os clientes exigem capacidades de câmara que excedam o que as empresas conseguem encaixar fisicamente nos seus dispositivos.

Para ler o estudo completo e verificar comparações adicionais entre DarkDiff e outros métodos de remoção de ruído, siga este link.

Ofertas de acessórios na Amazon

FTC: Usamos links de afiliados automotivos para geração de renda. Mais.