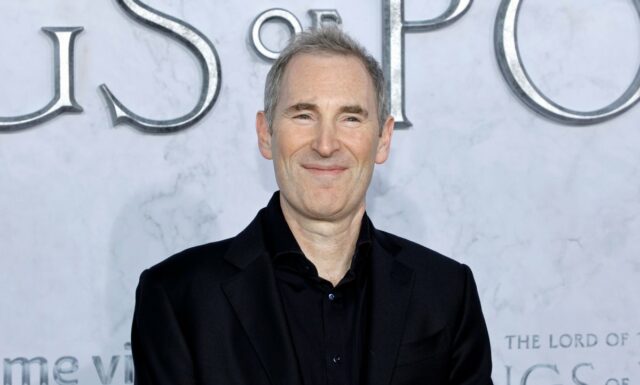

Alguma empresa, grande ou pequena, pode realmente derrubar o domínio dos chips de IA da Nvidia? Talvez não. Mas há centenas de bilhões de dólares em receitas para aqueles que conseguem até mesmo conseguir uma parte delas para si próprios, disse o CEO da Amazon, Andy Jassy, esta semana.

Como esperado, a empresa anunciou durante a conferência AWS Re:Invent a próxima geração de seu chip AI concorrente da Nvidia, Trainium3, que é quatro vezes mais rápido, mas usa menos energia do que o atual Trainium2. Jassy revelou algumas informações sobre o atual Trainium em um post no X que mostra por que a empresa está tão otimista com o chip.

Ele disse que o negócio Trainium2 “tem tração substancial, é um negócio com receita multibilionária, tem mais de 1 milhão de chips em produção e mais de 100 mil empresas que o utilizam como a maior parte do uso da Bedrock hoje”.

Bedrock é a ferramenta de desenvolvimento de aplicativos de IA da Amazon que permite às empresas escolher entre muitos modelos de IA.

Jassey disse que o chip de IA da Amazon está ganhando entre a enorme lista de clientes de nuvem da empresa porque “tem vantagens de preço-desempenho em relação a outras opções de GPU que são atraentes”. Ou seja, ele acredita que funciona melhor e custa menos do que aquelas “outras GPUs” que existem no mercado.

Esse é, obviamente, o MO clássico da Amazon, oferecendo sua própria tecnologia local a preços mais baixos.

Além disso, o CEO da AWS, Matt Garman, ofereceu ainda mais informações, em entrevista à CRN, sobre um cliente responsável por uma grande parte desses bilhões em receitas: Não é surpresa aqui, é a Antrópica.

Evento Techcrunch

São Francisco

|

13 a 15 de outubro de 2026

“Vimos uma enorme tração do Trainium2, especialmente de nossos parceiros da Anthropic, que anunciamos o Projeto Rainier, onde há mais de 500.000 chips Trainium2 ajudando-os a construir as próximas gerações de modelos para Claude”, disse Garman.

O Projeto Rainier é o cluster de servidores de IA mais ambicioso da Amazon, espalhado por vários data centers nos EUA e construído para atender às necessidades crescentes da Anthropic. Ele ficou online em outubro. A Amazon é, obviamente, uma grande investidora na Antrópica. Em troca, a Anthropic fez da AWS seu principal parceiro de treinamento de modelos, embora a Anthropic agora também seja oferecida na nuvem da Microsoft, por meio de chips da Nvidia.

OpenAI agora também usa AWS além da nuvem da Microsoft. Mas a parceria OpenAI não poderia ter contribuído muito para a receita da Trainium porque a AWS a executa em chips e sistemas Nvidia, disse a gigante da nuvem.

Na verdade, apenas algumas empresas norte-americanas como Google, Microsoft, Amazon e Meta possuem todas as peças de engenharia – experiência em design de chips de silício, interconexão de alta velocidade e tecnologia de rede desenvolvidas internamente – para tentar competir de verdade com a Nvidia. (Lembre-se, a Nvidia conquistou o mercado de uma importante tecnologia de rede de alto desempenho em 2019, quando o CEO Jensen Huang superou a oferta da Intel e da Microsoft para comprar a fabricante de hardware Infiniband, Mellanox.)

Além disso, os modelos de IA e software desenvolvidos para serem atendidos pelos chips da Nvidia também contam com o software Compute Unified Device Architecture (CUDA) proprietário da Nvidia. CUDA permite que os aplicativos usem as GPUs para computação de processamento paralelo, entre outras tarefas. Assim como a guerra de chips Intel vs. SPARC de ontem, não é pouca coisa reescrever um aplicativo de IA para um chip não CUDA.

Ainda assim, a Amazon pode ter um plano para isso. Como informamos anteriormente, a próxima geração de seu chip AI, Trainium4, será construída para interoperar com GPUs da Nvidia no mesmo sistema. Se isso ajuda a tirar mais negócios da Nvidia ou simplesmente reforça seu domínio, mas na nuvem da AWS, ainda está para ser visto.

Pode não importar para a Amazon. Se já estiver no caminho certo para faturar bilhões de dólares com o chip Trainium2, e a próxima geração for muito melhor, pode ser vencedor o suficiente.