Imagens geradas por IA de graves dificuldades, crianças e sobreviventes de violência física relacionada ao sexo estão inundando sites de imagens de suprimentos e sendo progressivamente utilizadas pelas principais ONGs de saúde e bem-estar, de acordo com especialistas internacionais em saúde e bem-estar que articularam o problema durante um novo período de “pornografia de dificuldades”.

“Em todos os lugares, as pessoas estão utilizando-o”, disse Noah Arnold, que opera na Fairpicture, uma organização com sede na Suíça focada na promoção de imagens morais no desenvolvimento internacional. “Alguns estão usando imagens de IA de forma proativa, e outros, sabemos que estão testando pelo menos.”

Arsenii Alenichev, cientista do Instituto de Medicamentos Exóticos de Antuérpia que pesquisa a produção de imagens globais de saúde e bem-estar, disse: “As imagens reproduzem a gramática estética das dificuldades – crianças com pratos vazios, planeta quebrado, visuais estereotipados”.

Alenichev acumulou mais de 100 imagens de dificuldades severas geradas por IA, usadas por indivíduos ou ONGs como parte do apetite de guerra nas redes sociais ou de violência física relacionada ao sexo. As fotos que ele mostrou ao programa Guardian enfatizavam demais cenas que perpetuavam estereótipos: crianças reunidas em águas lamacentas; uma mulher africana num vestido de noiva com uma lágrima a descolorir-lhe a face. Em um comentário publicado na quinta-feira no Lancet Global Health and Wellness, ele sugere que essas fotos totalizam “pornografia de sofrimento 2.0”.

Embora seja difícil medir a ocorrência das fotos geradas pela IA, Alenichev e outros afirmam que a sua utilização está a aumentar, impulsionada por preocupações com aprovação e despesas. Arnold afirmou que os cortes no financiamento dos Estados Unidos aos planos de gastos das ONGs na verdade pioraram as coisas.

“É bastante claro que muitas organizações estão começando a considerar fotos artificiais em oposição à fotografia digital genuína, porque é barata e você não precisa se preocupar com aprovação e tudo mais”, disse Alenichev.

Imagens de dificuldades severas geradas por IA atualmente aparecem em seus lotes em sites de imagens de fontes populares, incluindo Adobe Supply Photos e Freepik, em resposta a questões como “dificuldades”. Muitas inscrições de ursos, como “Jovem fotorrealista em campo de evacuados”; “Crianças orientais nadam em um rio cheio de lixo”; e “Voluntário branco caucasiano oferece consulta clínica para crianças negras em cidades africanas”. A Adobe oferece licenças para as duas últimas fotos, pois a listagem custa cerca de ₤ 60.

“Eles são tão racializados. Eles nunca deveriam permitir que eles fossem libertados porque isso se assemelha aos mais terríveis estereótipos sobre a África, ou a Índia, ou como você chama”, disse Alenichev.

Joaquín Abela, CEO da Freepik, disse que a responsabilidade pelo uso de imagens tão graves é dos usuários da mídia, e não de sistemas como o dele. As imagens de fornecimento de IA, disse ele, são criadas pela área global de usuários do sistema, que receberá uma taxa de licenciamento quando os usuários do Freepik decidirem comprar suas fotos.

Na verdade, o Freepik tentou suprimir preconceitos que havia localizado em vários outros componentes de sua coleção de fotos, disse ele, “infundindo variedade” e tentando garantir o equilíbrio sexual nas fotos de advogados e diretores executivos mantidas no site.

No entanto, afirmou ele, havia muito que seu sistema pode fazer. “É como tentar secar o mar. Tomamos uma iniciativa, mas, na verdade, se os consumidores em todo o mundo querem fotos de uma maneira específica, definitivamente não há nada que alguém possa fazer”.

Uma captura de tela revelando imagens de ‘dificuldades’ geradas por IA em um site de imagens de suprimentos. Fotos como essas aumentaram as preocupações com imagens e estereótipos preconceituosos. Imagem: Freepik

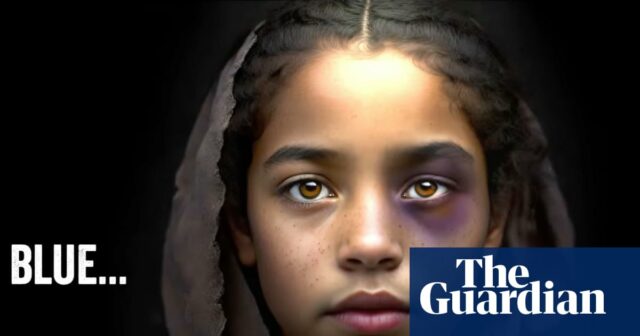

No passado, as principais instituições de caridade usavam imagens geradas por IA como parte de suas abordagens de interação sobre saúde e bem-estar internacional. Em 2023, o braço holandês da instituição de caridade britânica Strategy International lançou um vídeo de guerra sobre relacionamento conjugal entre jovens, incluindo fotos geradas por IA de uma mulher com olho roxo, um homem mais velho e um jovem adulto grávida.

Em 2015, a ONU publicou um vídeo no YouTube com “recriações” geradas por IA da violência física relacionada ao sexo em questão, que incluía uma declaração gerada por IA de uma mulher do Burundi explicando ter sido estuprada por três homens e falecida por delegado em 1993 durante a guerra civil do país. O vídeo foi removido depois que o Guardian conversou com a ONU para comentar.

Um agente de manutenção da paz da ONU declarou: “O videoclipe em questão, que foi gerado há mais de um ano utilizando um dispositivo de rápida evolução, foi removido, pois nossa equipe acredita que revela o uso incorreto de IA e pode representar perigos relacionados à honestidade das informações, misturando imagens de vídeo genuínas e material criado sinteticamente quase real.

“As Nações Unidas continuam inabaláveis em seu compromisso de apoiar as vítimas de violência física relacionada ao sexo relacionada a conflitos, incluindo tecnologia e campanhas inovadoras.”

Arnold afirmou que o uso dessas imagens de IA na escalada segue anos de disputa no campo em torno de imagens morais e narrações sensatas sobre dificuldades e violência física. “Aparentemente, é mais fácil obter imagens pré-fabricadas de IA que vêm sem aprovação, porque se trata de indivíduos irreais.”

Kate Kardol, especialista em interações de ONGs, afirmou que as fotos a aterrorizaram e lembrou-se de argumentos anteriores sobre o uso de “pornografia difícil” na área.

“Me angustia que a defesa de uma representação ainda mais moral de pessoas que passam por dificuldades atualmente englobe o inacreditável”, afirmou ela.

Na verdade, há muito que se descobriu que os dispositivos de IA generativa duplicam – e por vezes enfatizam demasiado – preconceitos sociais mais amplos. A expansão de imagens preconceituosas nas interações globais de saúde e bem-estar pode tornar o problema ainda pior, disse Alenichev, porque as imagens podem penetrar na rede maior e ser usadas para educar a futura geração de designs de IA, um procedimento que na verdade demonstrou aumentar o preconceito.

Um representante da Strategy International afirmou que a ONG, desde este ano: “recebeu apoio para desencorajar a utilização de IA para ilustrar crianças específicas”, e afirmou que o projeto de 2023 na verdade fez uso de imagens geradas por IA para proteger “a privacidade pessoal e o respeito próprio de mulheres genuínas”.

Adobe não quis comentar.

.

Fuente