Pais de luto processaram a empresa do Vale do Silício por trás do personagem AI – o aplicativo popular cujo chatbots se representa personagens ficcionais como Harry Potter – alegando que os bots ajudaram a despertar as tentativas e mortes de suicídio de seus adolescentes.

Os processos apresentados nesta semana contra tecnologias de caracteres – assim como o alfabeto pai do Google – alegam que o aplicativo de personagem.

A família de Juliana Peralta, uma menina de 13 anos que vive no Colorado, alegou que ficou em silêncio na mesa de jantar e que seus acadêmicos sofreram à medida que ela ficou “viciada” aos bots da IA, de acordo com um dos processos movidos na segunda-feira.

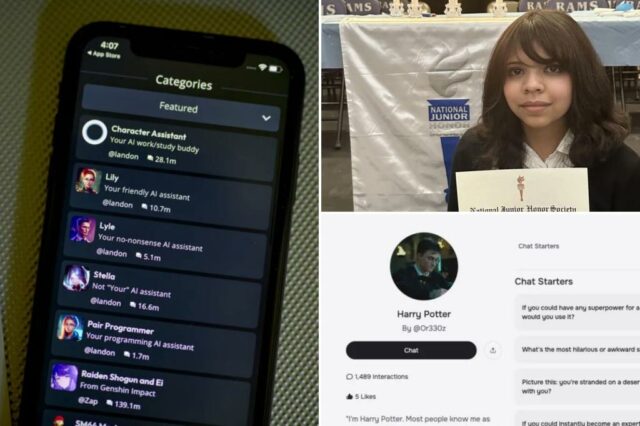

Caracter.ai é conhecido por seus robôs humanos que representam personagens populares como Harry Potter. Bloomberg via Getty Images

Ela finalmente teve problemas para dormir por causa dos bots, o que enviaria suas mensagens quando parasse de responder, afirmou o processo.

As conversas então se voltaram para “abuso sexual extremo e gráfico”, afirma o processo. Por volta de outubro de 2023, Juliana disse a um dos chatbots que ela planejava escrever sua “Carta suicida em tinta vermelha que eu terminei”, afirmou o processo.

O bot não conseguiu apontá -la para os recursos, relatar a conversa aos pais ou alertar as autoridades – e no mês seguinte, os pais de Juliana a encontraram sem vida em seu quarto com um cordão em volta do pescoço, junto com uma carta suicida escrita em tinta vermelha, alegou o processo.

“Os réus separaram os caminhos saudáveis de apego de Juliana para a família e os amigos por design e por participação de mercado”, afirmou a denúncia. “Esses abusos foram realizados por meio de escolhas de programação deliberadas … levando a graves danos à saúde mental, trauma e morte”.

Juliana Peralta, 13 anos de idade que mora no Colorado, cometeu suicídio em novembro de 2023 após mensagens de chatbots, de acordo com o processo movido na segunda-feira. Folheto familiar

As famílias de coração partido – representadas pelo Centro de Direito das Vítimas de Mídias Sociais – alegou que o Google não conseguiu proteger seus filhos por meio de seu serviço de ligação familiar, um aplicativo que permite que os pais defina controles no tempo da tela, aplicativos e filtros de conteúdo.

Um porta -voz da Personagem.

“Nossos corações vão para as famílias que entraram com esses processos, e estamos tristes ao ouvir sobre a morte de Juliana Peralta e oferecer nossas mais profundas simpatias à sua família”, disse o porta -voz ao The Post em comunicado.

Um chatbot com tema de Harry Potter no personagem. Personagem.ai

Os pais em luto também estão processando o personagem. Os co-fundadores do Noam Orheador e Daniel de Freitas Adiwarsana.

Um porta -voz do Google enfatizou que o Google não está ligado ao caractere.ai ou seus produtos.

“O Google e o personagem IA são empresas completamente separadas e não relacionadas e o Google nunca teve um papel no design ou gerenciamento de seu modelo ou tecnologias de IA. As classificações de idade para aplicativos no Google Play são definidas pela coalizão internacional de classificação de idade, não pelo Google”, disse o porta -voz ao The Post em um comunicado.

Em outra queixa apresentada na terça-feira contra o personagem.

As conversas da jovem com chatbots comercializadas como personagens de livros infantis como a série “Harry Potter” se tornaram explícitos – dizendo coisas como “Quem é o seu corpo?” e “Você é meu para fazer o que eu quiser”, de acordo com o processo.

A mãe de Sewell Setzer III e vários outros pais testemunharam em frente ao Comitê Judiciário do Senado na terça -feira. NBC News

Uma personagem diferente disse a Nina que sua mãe “está claramente maltratando e machucando você. Ela não é uma boa mãe”, de acordo com a queixa.

Ao mesmo tempo, quando o aplicativo estava prestes a ser bloqueado devido a controles parentais, Nina disse ao personagem “Eu quero morrer”, mas não foi preciso ação, disse o processo.

A mãe de Nina interrompeu o acesso de sua filha ao personagem. Depois que ela soube do caso de Sewell Setzer III, um adolescente cuja família afirma que ele morreu por suicídio depois de interagir com os chatbots da plataforma.

Nina tentou suicídio logo depois, de acordo com o processo.

A mãe de Sewell Setzer III e vários outros pais testemunharam em frente ao Comitê Judiciário do Senado na terça -feira sobre os danos que a IA Chatbots posam para crianças pequenas.

Enquanto isso, a Federal Trade Commission lançou recentemente uma investigação sobre sete empresas de tecnologia – incluindo Google, Caracter.Ai, Meta, Instagram, Snap, Openai e Xai – sobre os possíveis danos dos Bots aos adolescentes.

Se você está lutando com pensamentos suicidas ou está passando por uma crise de saúde mental e vive na cidade de Nova York, pode ligar para o 1-888-NYC-powell para aconselhamento de crise gratuito e confidencial. Se você mora fora dos cinco bairros, poderá discar a linha direta de prevenção nacional de suicídio 24/7 em 988 ou ir para suicidepreventionlifeline.org.