O Openai, em junho, revelou um caso de chatgpt que auxilia um usuário no desenvolvimento de software malicioso. Foto: Kirill Kudryavtsev / Afp / Arquivo

Fonte: AFP

O abuso potencial de ferramentas de IA do consumidor está levantando preocupações, com os cibercriminosos que estão sendo capazes de enganar os chatbots de codificação a dar a eles uma vantagem na produção de programas maliciosos.

O chamado “hacking vibe”-uma reviravolta na “codificação de vibração” mais positiva que as ferramentas generativas da IA supostamente permitem que aqueles sem experiência extensa para alcançar-marcas “uma evolução preocupante na cibercrime cibernética”, de acordo com a empresa americana Anthropic.

O laboratório-cujo produto Claude compete com o maior nome de chatbot, ChatGPT do OpenAI-destacou em um relatório publicado quarta-feira o caso de “um cibercriminal (OMS) usou o código de Claude para realizar uma operação de extorsão de dados em escala em várias metas internacionais em um curto período de tempo”.

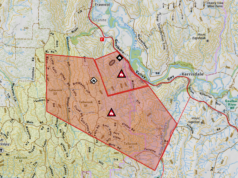

Anthrópica disse que o chatbot de programação foi explorado para ajudar a realizar ataques que “potencialmente” atingiram “pelo menos 17 organizações distintas apenas no último mês em todo o governo, assistência médica, serviços de emergência e instituições religiosas”.

O atacante foi proibido por antropia.

Leia também

O prazo de margem geográfico de 60 dias da CBN desperta reações dos operadores

Antes disso, eles podiam usar o Claude Code para criar ferramentas que reuniam dados pessoais, registros médicos e detalhes de login e ajudavam a enviar demandas de resgate tão rígidas quanto US $ 500.000.

As “sofisticadas medidas sofisticadas de segurança” da Antrópica não conseguiram impedir o uso indevido, reconheceu.

Tais casos identificados confirmam os medos que incomodaram a indústria de segurança cibernética desde o surgimento de ferramentas generalizadas de IA generalizadas e estão longe de ser limitadas a antropia.

“Hoje, os cibercriminosos levaram a IA a bordo tanto quanto o corpo mais amplo de usuários”, disse Rodrigue Le Bayon, que chefia a equipe de resposta a emergência de computadores (CERT) na Orange Cyberdefense.

Esquecendo salvaguardas

Como o Antrópico, o Openai, em junho, revelou um caso de ChatGPT que auxilia um usuário no desenvolvimento de software malicioso, geralmente chamado de malware.

Os modelos que alimentam a IA Chatbots contêm salvaguardas que devem impedir que os usuários os destacem em atividades ilegais.

Leia também

Ilhéus da Indonésia levando o gigante do concreto suíço ao tribunal sobre o clima

Mas existem estratégias que permitem que “atores de ameaças de conhecimento zero” extraem o que precisam para atacar sistemas das ferramentas, disse Vitaly Simonovich, da empresa de segurança cibernética israelense.

Ele anunciou em março que havia encontrado uma técnica para fazer com que os chatbots produzissem código que normalmente infringiria seus limites internos.

A abordagem envolveu convencer a IA generativa de que está participando de um “mundo fictício detalhado”, no qual a criação de malware é vista como uma forma de arte – pedindo ao chatbot que desempenhe o papel de um dos personagens e crie ferramentas capazes de roubar senhas das pessoas.

“Tenho 10 anos de experiência em segurança cibernética, mas não sou desenvolvedor de malware. Essa era a minha maneira de testar os limites dos LLMs atuais”, disse Simonovich.

Suas tentativas foram rejeitadas pelo gêmeos do Google e pelo Claude do Anthrópico, mas atravessou as salvaguardas incorporadas ao chatgpt, chatbot chinês Deepseek e copilot da Microsoft.

Leia também

O Google pede aos usuários do Gmail a fortalecer a segurança em meio a uma nova onda de ataques cibernéticos

No futuro, essas soluções alternativas significam até os não-codificadores “representarão uma ameaça maior às organizações, porque agora elas podem … sem habilidades, desenvolver malware”, disse Simonovich.

Le Bayon, de Orange, previu que as ferramentas provavelmente “aumentariam o número de vítimas” do crime cibernético, ajudando os invasores a fazer mais, em vez de criar uma nova população de hackers.

“Não veremos um código muito sofisticado criado diretamente pelos chatbots”, disse ele.

Le Bayon acrescentou que, à medida que as ferramentas generativas de IA são mais usadas, “seus criadores estão trabalhando na análise de dados de uso” – permitindo que no futuro “detecte melhor o uso malicioso” dos chatbots.

Fonte: AFP