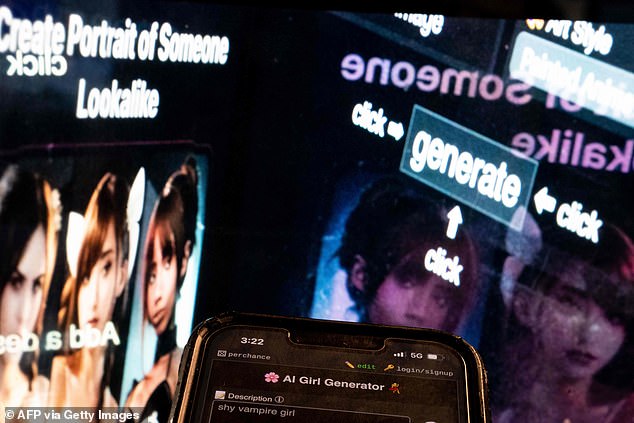

Especialistas alertaram sobre “uma explosão maciça” em meninos – alguns a mais de 13 anos – com programas gratuitos de IA para criar imagens nus e animadas de outros alunos.

Alega-se que as meninas foram levadas ao suicídio depois de serem vítimas dos chamados aplicativos de smartphones “nudificantes”.

Os aplicativos podem transformar imagens completamente vestidas de colegas de classe-bem como uma aparência de professor para aparência realista de nus explícitos. Acredita -se que eles estejam em uso em “todas as salas de aula” e os adolescentes já foram condenados por criar e compartilhar as fotos.

De acordo com a lei atual, criar, manter e distribuir uma imagem indevida de uma criança que tem condições significativas da prisão.

Marcus Johnstone, advogado de defesa criminal, disse que houve uma “explosão maciça” em crimes de crianças que muitas vezes não sabem quão graves são suas ações.

“Estou ciente de que alguns autores têm 13 anos, mas têm principalmente 14 e 15 anos”, disse ele. – Mas eles ficam mais jovens.

“Até as crianças nas escolas primárias têm conhecimento e assistem pornografia em seus telefones. Isso acontece na maioria das escolas e faculdades do ensino médio, se não todas, do ensino médio.

“Espero que cada sala de aula tenha alguém que use a tecnologia para nutrir fotografias ou criar imagens de Deepfake.

Especialistas alertaram sobre “uma explosão maciça” em meninos – alguns a mais de 13 anos – usam programas de IA gratuitos para criar fotos nus animadas de outros alunos

As postagens no LinkedIn parecem até comercializar as “melhores” ferramentas de IA nudificantes

“Ele tem um efeito devastador nas meninas – que quase sempre são as vítimas. Isso afeta sua saúde mental. Ouvimos histórias de suicídio”.

O comissário das crianças Dame Rachel de Souza pediu ao governo que “vá muito mais longe e mais rápido” para proteger as crianças e disse ao Posten no domingo que os aplicativos “são seriamente prejudiciais e que sua existência é um escândalo”.

Ela acrescentou: ‘Aplicativos de nudificação simplesmente não devem existir. Não deve ser possível para um aplicativo gerar uma imagem sexual de uma criança, seja sua intenção projetada ou não. ‘

Entre os casos criminais anteriores, um garoto de Midland recebeu uma referência de nove meses por fazer 1.300 fotos decentes de uma criança, começando quando ele tinha 13 anos.

E um garoto de 15 anos no Sudeste recebeu uma referência de nove meses depois de fazer muitas fotos indevidas, também começou quando ele tinha 13 anos.

Espera -se que a proposta de crime e policial 2025 introduza um novo crime para criar fotos ou filmes “Deepfake” sexualmente explícitos.

Um advogado de defesa criminal disse que houve uma “explosão maciça” em crianças criando imagens indevidas sem estar ciente de quão sérias são suas ações (imagem do arquivo)

A gigante da tecnologia Meta Sues, Joy Timeline, da empresa de Hong Kong, nas alegações do meio que estava por trás de aplicativos de nudificação, incluindo grátis para baixar o Crushai.

Seguiu relatos de que havia comprado milhares de anúncios no Instagram e no Facebook, com vários perfis falsos para evitar metas moderadores.

Derek Ray-Hill, da Internet Watch Foundation, disse: “Isso é imagens nuas e sexuais de crianças de verdade-foda-se extremamente animada-enquanto vemos cada vez mais cair nas mãos dos criminosos on-line com as piores intenções”.

As estatísticas mais recentes mostram que houve aproximadamente 1400 crimes sexuais comprovados envolvendo bens de crianças na Inglaterra e no País de Gales durante o ano até março de 2024 – quase um aumento de 50 % em comparação com os últimos 12 meses.

Lágrimas de adolescente preto preso sobre a foto

Por Cameron Lane

Uma colegial descreveu ser extorquada depois que ela conseguiu uma imagem pornográfica falsa de si mesma.

Embora ela não seja identificada, a ansiedade que ela expressa em seu post online reflete um exame que se torna conhecido nas salas de aula em todo o país.

A garota disse que nunca tirou uma foto nua sozinha, então ficou surpresa quando tirou a foto explícita gerada pela IA “do nada”.

Em um post no Fórum Online Reddit, ela disse que chorou quando viu a foto e a descreveu como “o trabalho de algum mal”.

Ela apelou a outros usuários do Reddit para obter conselhos e perguntou: “Há algo que eu possa fazer?”